大语言模型的推理能力,简单来说,就是让模型像人一样“动脑子思考”,根据已经知道的信息来得出新的结论或者做出合理的判断。

大语言模型首先要能理解输入给它的各种信息,就像我们看一篇文章、听别人说话要明白是什么意思一样。比如你给它一段关于动物习性的描述,它得知道说的是哪种动物,有什么特点等。然后,它还要能对这些信息进行分析,把重要的部分挑出来,就像我们读完一篇文章后总结重点一样。例如,给模型输入“猫喜欢抓老鼠,老鼠会打洞,猫有锋利的爪子”这段话,它能理解这是在说猫和老鼠的一些特性,并分析出猫和老鼠的行为特点以及猫的身体特征这些关键信息。

一、基本概念

1.逻辑推理与关联

大语言模型要能够根据分析出来的信息,找到它们之间的逻辑关系,然后进行推理。就像我们知道“如果下雨地面就会湿”,看到地面湿了就会推测可能下过雨了一样,模型也得有这种根据已知条件进行合理推测的能力。

比如,告诉模型“鸟会飞,麻雀是一种鸟”,它就能推理出“麻雀会飞”。这就是利用了“鸟”和“会飞”之间的逻辑关系,以及“麻雀”属于“鸟”这个类别关系,从而得出了新的结论。

2.解决问题与决策

有了前面的理解、分析和推理能力,大语言模型就可以用来解决各种问题和做出决策了。比如你问它“我要去一个经常下雨的地方旅行,应该带什么”,它会根据对“下雨”这个情况的理解和相关知识的推理,告诉你要带雨伞、雨衣、防水的鞋子等物品。

再比如,在玩一些策略游戏时,模型可以根据游戏当前的局面,分析各种可能的行动方案,然后推理出哪种方案更有可能获胜,从而给玩家提供建议或者自己做出决策来进行游戏。

3.语言生成与表达

大语言模型的推理能力还体现在它生成语言的时候。它不是随便乱说,而是会根据前面的信息和推理结果,用合理、连贯的语言把自己“想”的内容表达出来。比如它在写故事的时候,会根据已经设定的情节和人物特点,推理出接下来可能发生的事情,然后用生动的语言把故事继续编下去。

例如,它写一个冒险故事,前面提到主人公在森林里遇到了一条大河,没有桥。接下来它就会推理主人公可能会想办法找木头搭桥,或者找船过河等,然后用文字把这些情节描述出来,让故事变得很精彩。

二、技术进展

1.逻辑推理能力显著提升:模型在部分任务上表现优异。在自然语言处理的很多常规任务中,如文本生成、智能客服中的简单问题回答等,大语言模型能根据输入生成较为合理、连贯的内容,展现出了较好的推理和理解能力。一些专门为提升推理能力设计的模型,如阿里巴巴的Marco O1,在处理自然语言任务时,能更好地理解语义和逻辑关系,提高了推理和判断的准确性。2024年9月OpenAI发布推理模型o1,并在12月迅速升级到o3版本,新模型在数学、编程、博士级科学问答等复杂问题上,表现出超越部分人类专家的水平。谷歌也在12月发布其最新推理模型“双子座2.0闪电思维”,专注于解决编程、数学及物理等领域的难题。

2.多种模型涌现展现强劲实力:除了OpenAI和谷歌的模型外,上海人工智能实验室发布的书生·浦语大模型及其强推理模型InternThinker,具有深度的思维与反思能力,能在数学、代码和复杂推理任务中展现优异性能。月之暗面Kimi的k0-math逼近OpenAI的o1系列,将数学能力提升至新高度。DeepSeek的DeepSeek-R1-Lite通过强化学习,在数学与逻辑推理任务上实力强劲。

3.推理技术应用创新:大语言模型LLM的推理引擎有了新发展,主流方案有开源的vLLM和半闭源的TensorRT-LLM。vLLM有技术创新、兼顾性能和易用性、开源社区成熟、支持多硬件等优势;TensorRT-LLM在其重点支持的场景里,性能可做到极致。OpenAI在o3中应用“推理时计算”技术,使其在编程能力和数学推理测试中的表现显著提升,在真实世界软件任务评估中,o3的编程准确率达到71.7%,在美国数学奥林匹克考试(AIME)中,准确率高达96.7%。

三、发展趋势

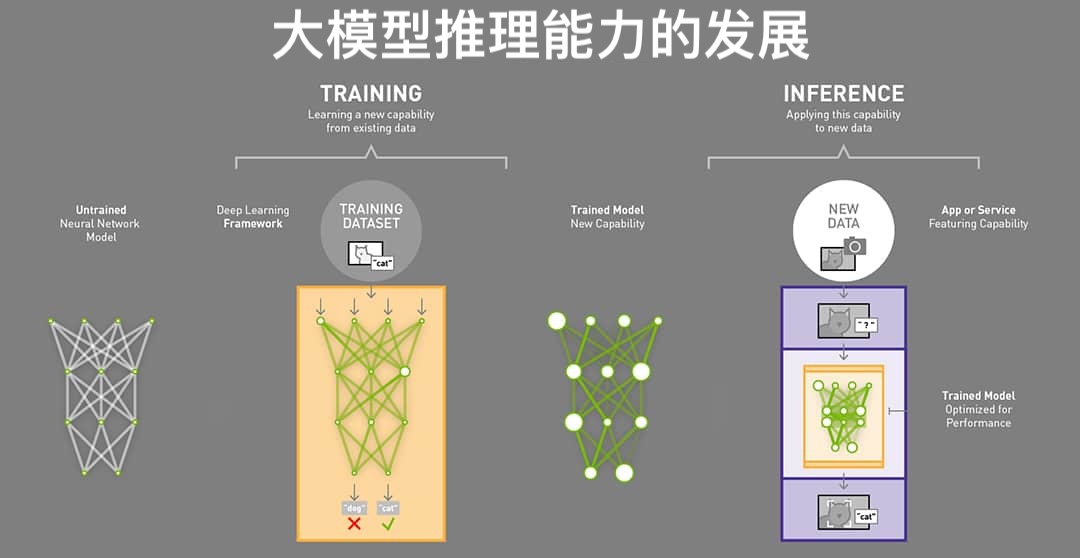

1.从训练转向推理:企业人工智能的关注点将逐步从模型训练转向推理,大量企业在AI推理的基础设施上投入重金,以适应在不同环境中动态运行的需要,无论是云计算还是边缘设备,推理的需求都将快速增长。

2.强化学习受重视:未来模型的训练将更多依赖于后期的强化学习过程,强化学习的大规模应用将成为未来的重点,通过提高模型的搜索效率和训练出泛化能力强的奖励模型,为模型的推理表现提供反馈。

3.探索新型架构:AI领域正在不断探索新型模型架构,以克服现有架构(如Transformer)在计算效率及可扩展性方面的局限,状态空间模型、图形模型和接受权重键值(RWKV)模型等新架构,正在成为备受关注的研究方向。

四、面临挑战

1.逻辑推理的真实性存疑:苹果公司的研究显示,大语言模型在面对微调后的数学应用题时,答题正确率显著下降,模型可能只是依靠“记忆”能力和模式匹配来处理问题,而非真正的逻辑推理。

2.复杂推理任务表现不佳:在多跳知识推理中,模型可能依赖预训练阶段的事实捷径,归纳推理在任务复杂程度增大时准确率降低,在逆向知识搜索、比较和分类等任务上,大语言模型的表现也不尽如人意。

3.对数据依赖程度过高:大语言模型推理能力的提升高度依赖大量准确和多样的数据输入,数据的质量和多样性直接影响模型的推理效果,若数据存在偏差或不足,模型的推理能力就会受到限制。目前高密度监督数据匮乏,使得模型难以充分学习高难度问题的解法,需要开发更有效的数据构造方法。

4.成本问题:像OpenAI的o3等先进模型,训练与应用成本极高,在高算力配置下,执行每个ARC - AGI测试任务的费用达到3400美元,这对其商业化应用形成严重障碍。

5.伦理安全问题:AI的社会影响力在增大,当AI具备了超越人类理解的推理能力,引发了关于智能与知识关系的思考,以及AI生成“幻觉”现象的讨论,在医疗、金融等关键领域应用时,模型产生不准确信息的问题对其应用提出了严峻挑战。