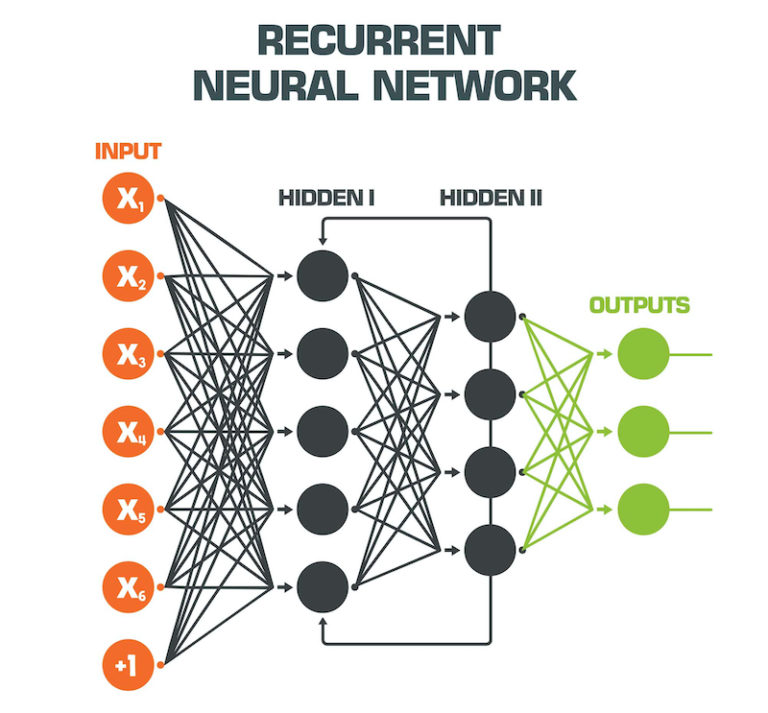

循环神经网络(Recurrent Neural Networks,RNN)是一种适合于处理序列数据的神经网络。它与传统的前馈神经网络(Feedforward Neural Networks,FNN)不同,RNN能够处理序列中的动态信息,并且能够处理任意长度的序列。

一、RNN的主要特点:

**循环连接**:RNN的核心在于它的循环连接,即网络的输出会作为下一个时间步的输入,这使得网络能够保持对之前信息的记忆。

**参数共享**:在RNN中,无论序列的长度如何,使用的权重和参数是共享的。

**记忆能力**:RNN能够记住序列中的信息,这使得它在处理时间序列数据、自然语言处理等领域表现出色。

二、RNN的工作原理:

RNN的工作原理可以概括为以下几个步骤:

**初始化状态**:在序列的开始,RNN会有一个初始隐藏状态,通常是一个零向量或通过某种方式初始化。

**序列处理**:对于序列中的每个元素,RNN会计算当前时间步的隐藏状态。这通常通过一个激活函数(如tanh或ReLU)来完成。

**信息传递**:隐藏状态会传递到下一个时间步,与新的输入一起更新。

**输出生成**:在每个时间步,RNN可以生成一个输出,这通常通过另一个激活函数来完成。

**序列结束**:当序列结束时,RNN可以输出最终的隐藏状态,或者通过一个额外的输出层来生成最终的预测。

三、RNN的变体:

**长短期记忆网络(LSTM)**:为了解决RNN在处理长序列时的梯度消失或梯度爆炸问题,LSTM引入了门控机制来控制信息的流动。

**门控循环单元(GRU)**:GRU是LSTM的一个变体,它简化了门控机制,将LSTM中的遗忘门和输入门合并为一个更新门。

**双向RNN(Bi-RNN)**:Bi-RNN在每个时间步同时处理过去和未来的信息,这使得它能够更好地理解序列的上下文。

四、RNN的应用

**自然语言处理(NLP)**:RNN在自然语言处理领域有广泛的应用,包括语言模型的构建、文本分类、情感分析、机器翻译、语音识别等。

**语音识别**:RNN可以处理时间序列的音频数据,用于语音到文本的转换,广泛应用于智能助手、自动字幕生成等场景。

**文本生成**:RNN能够生成连贯和上下文相关的文本内容,用于撰写新闻报道、生成创意文本等。

**聊天机器人**:利用RNN的聊天机器人能够提供更自然、更符合人类对话风格的交互体验。

**自动翻译系统**:RNN在自动翻译系统中用于理解和翻译不同语言,提供更准确和自然的翻译结果。

**医疗领域**:RNN在医疗领域中用于疾病预测、患者监护,分析医疗记录和健康数据,辅助医生做出更准确的诊断。

**金融市场预测**:在金融领域,RNN用于预测股市走势、风险管理,分析历史交易数据和市场趋势。

**视频处理**:结合卷积神经网络,RNN可以用于视频内容理解、行为识别等计算机视觉问题。

**生物信息学**:RNN分析基因序列、预测蛋白质结构,帮助理解复杂的生物过程。

**时间序列分析**:在地球科学、气象学等领域,RNN用于建模和预测时间序列变量,如土壤湿度模拟、降水-径流模型等。

**音乐生成**:RNN可以根据音乐序列生成新的音乐作品,模仿特定风格的音乐创作。

**诗歌创作**:RNN能够创作诗歌,生成与原作相似性极高的文字序列,用于艺术创作和内容生成。

这些应用展示了RNN在商业领域的多样性和潜力,随着技术的进一步发展,RNN在商业领域的应用将更加广泛和深入。

五、Python应用

在Python中,循环神经网络(RNN)的应用可以通过多种深度学习框架来实现,其中最流行的包括TensorFlow和PyTorch。以下是使用这两种框架实现RNN的一些基本步骤和示例代码。

### 使用TensorFlow实现RNN

TensorFlow提供了一个高级API `tf.keras`,它使得构建RNN变得相对简单。以下是一个使用TensorFlow构建RNN的简单示例:

```python

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import SimpleRNN, Dense

# 假设我们有输入数据X和目标数据y

X = ... # 输入数据,形状为 [batch_size, timesteps, input_dim]

y = ... # 目标数据

# 构建一个简单的RNN模型

model = Sequential()

model.add(SimpleRNN(50, return_sequences=True, input_shape=(X.shape[1], X.shape[2])))

model.add(Dense(1))

# 编译模型

model.compile(loss='mean_squared_error', optimizer='adam')

# 训练模型

model.fit(X, y, epochs=10, batch_size=32)

```

### 使用PyTorch实现RNN

PyTorch提供了更多的灵活性,但需要手动管理更多的细节。以下是一个使用PyTorch构建RNN的示例:

```python

import torch

import torch.nn as nn

class RNNModel(nn.Module):

def __init__(self, input_size, hidden_size, output_size):

super(RNNModel, self).__init__()

self.rnn = nn.RNN(input_size, hidden_size, batch_first=True)

self.fc = nn.Linear(hidden_size, output_size)

def forward(self, x):

# x的形状为 [batch_size, timesteps, input_size]

output, hidden = self.rnn(x)

# 取隐藏状态的最后一个时间步

output = output[:, -1, :]

output = self.fc(output)

return output

# 实例化模型

input_size = 10

hidden_size = 20

output_size = 1

model = RNNModel(input_size, hidden_size, output_size)

# 定义损失函数和优化器

criterion = nn.MSELoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.001)

# 假设我们有输入数据X和目标数据y

X = ... # 输入数据,形状为 [batch_size, timesteps, input_size]

y = ... # 目标数据

# 训练模型

for epoch in range(10):

outputs = model(X)

loss = criterion(outputs, y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

print(f'Epoch {epoch+1}, Loss: {loss.item()}')

```

在实际应用中,你需要根据具体任务调整模型结构、超参数以及训练过程。此外,RNN的变体如LSTM和GRU在处理长序列数据时通常表现更好,因此在实际应用中可能会更倾向于使用这些变体。

RNN是一种强大的模型,能够处理复杂的序列数据,但它也有局限性,如难以训练和难以捕捉长距离依赖关系。因此,研究人员开发了LSTM和GRU等改进模型来解决这些问题。