ResNet是一种深度学习神经网络架构,在图像识别等领域有着广泛的应用和重要的地位。

随着神经网络深度的增加,会出现梯度消失、退化问题等。梯度消失会导致模型难以训练,而退化问题则表现为随着网络层数的增加,模型的准确率反而下降。ResNet的提出就是为了解决这些问题,使得训练极深的神经网络成为可能。

早期,随着神经网络层数的逐步增加,研究人员原本期待模型能够学习到更复杂、更抽象的特征,从而提升性能。然而,实际情况却事与愿违,网络出现了梯度消失、退化等棘手问题。梯度消失现象,简单来说,是在反向传播过程中,梯度在经过多层传递后变得极小,导致参数更新缓慢甚至停滞,使得模型难以训练。而退化问题更令人困惑,当网络层数不断叠加,模型在训练集和测试集上的准确率不仅没有提升,反而开始下降,这与人们对深度网络的预期背道而驰 。在这样的技术困境下,2015 年,微软研究院的何恺明等人提出了 ResNet(Residual Network),即残差网络。

一、原理

1.残差学习

传统的深度学习神经网络,在构建输入到输出的映射关系时,采用的是直接学习的方式。例如在图像分类任务中,输入图像数据,神经网络试图直接从这些像素信息中学习到能够准确分类图像类别的映射。但随着网络层数的增加,这种直接映射的学习难度呈指数级增长,网络参数优化变得极为困难。ResNet 则另辟蹊径,引入了残差学习的概念。它不再让网络直接学习复杂的输入 - 输出映射\\(H(x)\\),而是学习残差函数\\(F(x)=H(x)-x\\)。其中,\\(x\\)代表输入数据,\\(H(x)\\)是期望网络学习到的理想映射,\\(F(x)\\)就是残差。打个比方,如果把网络看作是一个不断对输入进行加工处理的工厂,传统网络是直接将原材料(输入)加工成最终产品(输出),而 ResNet 的残差学习方式则是先假设原材料本身已经具备了部分成品的特征,网络只需要学习如何将原材料中不满足成品要求的部分进行改进,也就是学习残差。这样一来,网络学习的目标更加明确,难度大幅降低,训练过程也变得更加高效。

2.恒等映射

残差连接所形成的恒等映射,是 ResNet 解决梯度消失和网络退化问题的关键所在。在残差块中,当网络学习到的残差\\(F(x)\\)为 0 时,整个残差块的输出就等于输入,即完成了恒等映射。这就好比在网络中搭建了一条 “信息高速公路”,信号可以毫无阻碍地从输入直接传递到输出,避免了在深层网络传递过程中可能出现的信息丢失和梯度衰减。在反向传播过程中,由于恒等映射的存在,梯度能够更顺畅地反向流动,不会因为网络层数过深而逐渐消失,从而使得网络能够训练到更深的层次。例如,在训练一个非常深的 ResNet 网络时,即使网络层数达到几十层甚至上百层,由于恒等映射的作用,网络依然能够有效地进行参数更新,保证了模型的训练效果。

二、网络结构

1.残差块

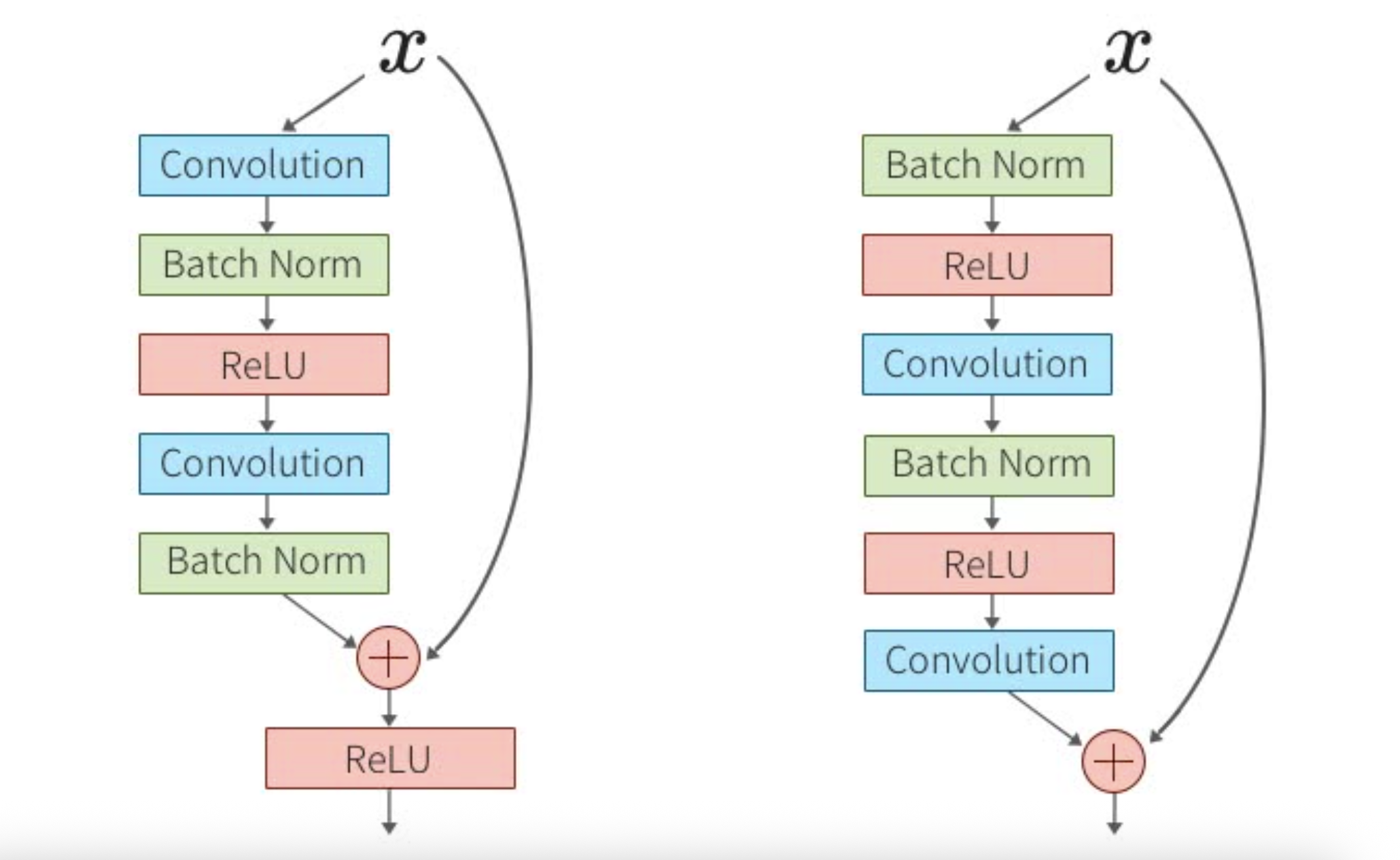

残差块作为 ResNet 的基石,其结构设计精妙且灵活多变。一般来说,残差块内部通常包含两个或多个卷积层,这些卷积层负责对输入数据进行特征提取;批量归一化层(Batch Normalization)的加入,则能够对数据进行归一化处理,加速网络的收敛速度,提高模型的稳定性;激活函数如 ReLU(Rectified Linear Unit),为网络引入非线性因素,增强网络的表达能力。同时,残差连接将输入直接与卷积层的输出相加,形成独特的结构。根据不同的应用场景和网络深度需求,ResNet 衍生出了多种残差块变体,其中最具代表性的是 Basic Block 和 Bottleneck Block。

Basic Block:它由两个 3×3 的卷积层串联组成,结构相对简单,适用于构建像 ResNet18 和 ResNet34 这样相对较浅的网络。在 Basic Block 中,输入数据依次经过两个 3×3 卷积层,进行特征提取和变换,然后与原始输入相加,得到最终输出。这种简单而有效的结构,在浅层网络中能够很好地发挥作用,平衡计算量和特征提取能力。

Bottleneck Block:主要应用于 ResNet50、ResNet101 等更深层次的网络架构。它通过 1×1 卷积来降低输入数据的维度,大幅减少后续 3×3 卷积层的计算量,在经过 3×3 卷积层进一步提取特征后,再利用 1×1 卷积恢复数据维度。这种 “先降维 - 再卷积 - 后升维” 的结构,就像一个瓶颈,在保证网络能够提取到丰富特征的同时,有效控制了计算复杂度,使得构建超深网络成为可能。

2.整体架构

从整体来看,ResNet 是由多个残差块按照特定的顺序堆叠而成的深层网络结构。在网络的起始部分,通常会设置一个初始卷积层,对输入图像进行初步的特征提取和下采样处理,降低数据维度,减少后续计算量;紧接着是一系列不同数量和类型的残差块,它们是网络的核心部分,层层递进地对特征进行提取和抽象;在网络的末端,一般会包含池化层和全连接层。池化层用于进一步降低数据维度,提取关键特征;全连接层则将提取到的特征进行整合,并根据具体任务输出分类结果或回归预测值。例如在图像分类任务中,全连接层会输出图像属于各个类别的概率值,通过选取概率最大的类别,实现对图像的分类。

三、优点

1.解决梯度消失和退化问题

ResNet 的残差连接机制,为解决梯度消失和网络退化问题提供了完美的解决方案。在传统深层神经网络中,随着网络层数的增加,梯度在反向传播过程中逐渐变小,甚至趋近于 0,导致网络参数无法有效更新,模型难以训练。而 ResNet 通过残差连接,使得梯度能够沿着恒等映射路径直接反向传播,保证了梯度在深层网络中的稳定性和有效性。同时,网络的退化问题也得到了妥善解决,因为即使网络层数不断增加,只要残差块能够学习到有效的残差信息,模型的性能就不会下降,反而会随着深度的增加而不断提升。例如,在 ImageNet 图像分类数据集上的实验表明,使用 ResNet 训练的超深网络,其准确率随着层数的增加呈现稳步上升的趋势,远远超过了传统网络的表现。

2.易于优化

残差学习的模式使得 ResNet 在优化过程中具有天然的优势。由于网络只需要学习输入与输出之间的残差部分,而不是直接学习复杂的映射关系,这大大降低了网络的学习难度。在训练过程中,网络可以更加专注于学习数据中细微的差异和变化,而不需要从头开始构建复杂的特征映射。例如,在训练一个用于识别手写数字的 ResNet 模型时,网络可以快速学习到不同数字之间的细微差异,而不是像传统网络那样需要花费大量的时间和计算资源去学习整个数字图像的复杂特征表示,从而使得模型的训练过程更加高效,收敛速度更快。

3.特征重用

残差连接的存在,使得网络中不同层的特征能够得到充分的重用。在传统神经网络中,随着网络层数的增加,信息在传递过程中容易丢失,高层特征与低层特征之间的联系不够紧密。而在 ResNet 中,输入数据可以直接跳过中间层,与后续层的输出相加,这使得低层的特征能够直接参与到高层特征的构建中。例如,在图像识别任务中,低层特征可能包含了图像的边缘、纹理等基础信息,这些信息通过残差连接直接传递到高层,与高层提取的语义特征相结合,有助于模型学习到更丰富、更全面的图像特征表示,从而提高模型的识别准确率和泛化能力。

四、应用

1.图像识别

自诞生以来,ResNet 在图像识别领域便展现出了强大的统治力。在具有全球影响力的 ImageNet 图像分类挑战赛中,基于 ResNet 架构的模型多次刷新了比赛纪录,大幅提高了图像分类的准确率。例如,ResNet - 50、ResNet - 101 等模型在识别各种复杂图像时,能够准确捕捉图像中的关键特征,对图像进行精准分类。此外,在实际应用中,如安防监控系统中的人脸识别、智能交通系统中的车辆识别等场景,ResNet 也发挥着重要作用,通过对海量图像数据的学习和分析,实现高效、准确的图像识别任务。

2.目标检测

在目标检测任务中,ResNet 常常作为骨干网络,为目标检测算法提供强大的特征提取能力。例如,在经典的 Faster R - CNN、YOLO 等目标检测算法中,ResNet 能够从输入图像中提取出多层次、多尺度的特征图,这些特征图包含了丰富的目标信息。算法基于这些特征图,通过区域建议生成、目标分类和边界框回归等步骤,实现对图像中多个目标的精准定位和识别。与传统的特征提取网络相比,使用 ResNet 作为骨干网络的目标检测算法,在检测精度和速度上都有了显著提升,能够更好地满足实际应用场景的需求,如自动驾驶中的障碍物检测、工业检测中的产品缺陷识别等。

3.语义分割

语义分割旨在对图像中的每个像素进行分类,从而实现对图像的语义理解,这在计算机视觉领域具有重要的应用价值。ResNet 凭借其强大的特征提取能力和深层网络结构,在语义分割任务中也取得了广泛应用。例如,在一些基于深度学习的语义分割算法中,以 ResNet 为基础进行网络架构设计,通过对输入图像进行多层特征提取和上采样操作,能够准确地将图像中的不同物体和区域进行分割,并赋予每个像素相应的语义标签。在医疗影像分析中,语义分割技术可以帮助医生对病变区域进行精准定位和分析;在城市规划领域,通过对遥感图像的语义分割,可以实现对城市建筑、道路、绿地等不同地物的识别和统计,为城市规划和管理提供重要的数据支持。