在语音合成(TTS)技术从 “分步拼接” 向 “端到端生成” 演进的过程中,谷歌于 2017 年开源的 Tacotron 2 模型无疑是里程碑式的存在。它首次打破传统 TTS“文本预处理→音素预测→韵律建模→语音合成” 的多阶段流程,构建了 “文本直接映射至语音” 的端到端框架,为后续开源 TTS 技术的发展奠定了核心架构基础。

一、项目核心信息

1. 项目介绍

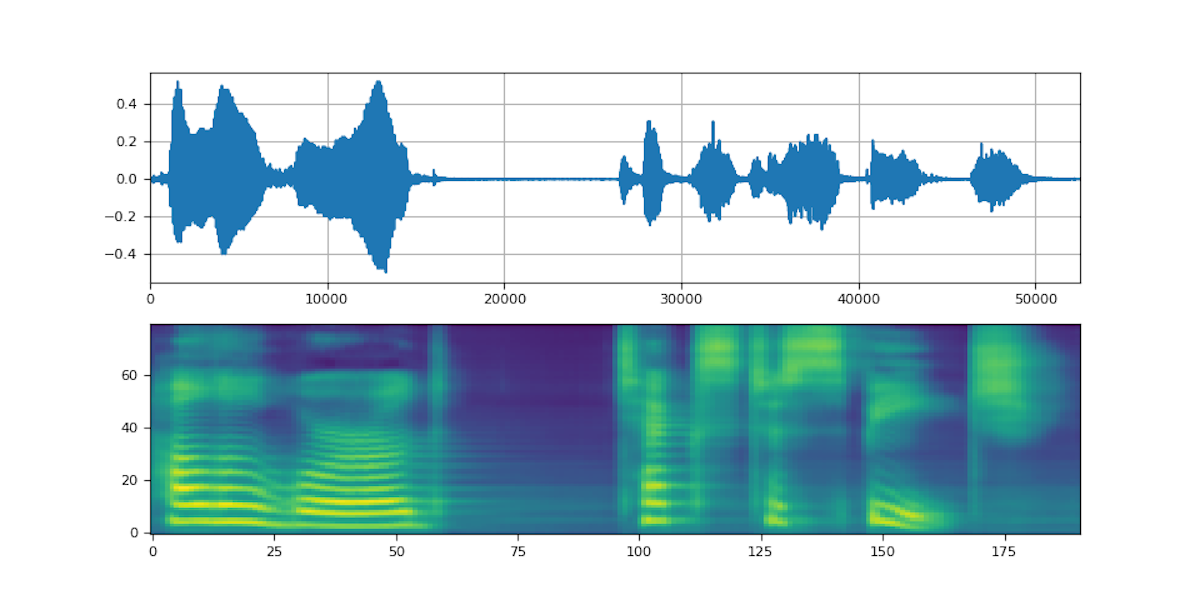

Tacotron 2 是谷歌 DeepMind 团队研发的端到端语音合成模型,发表于 2017 年的论文《Natural TTS Synthesis by Conditioning WaveNet on Mel Spectrograms》。其核心突破在于将 “文本特征提取→梅尔频谱生成→语音波形合成” 三个关键步骤整合为统一模型,搭配谷歌同期提出的 WaveNet 声码器后,可生成接近人类自然语音的合成效果,彻底改变了此前开源 TTS“音质粗糙、流程复杂” 的局面。

2. 项目地址

作为谷歌开源生态的重要组成部分,Tacotron 2 的核心实现代码托管于谷歌 TensorFlow 官方模型仓库,开发者可直接获取源码、预训练模型及训练教程:

GitHub 地址:https://github.com/NVIDIA/tacotron2

二、技术原理:端到端的 “文本→语音” 生成链路

Tacotron 2 采用 “编码器 - 解码器 + 声码器” 的三段式架构,核心逻辑是通过端到端学习,跳过传统 TTS 的中间人工设计步骤(如音素对齐),直接从文本生成可听语音,具体流程如下:

1. 文本特征编码(Encoder)

输入:原始文本序列(如英文句子);

处理流程:先通过字符嵌入层(Character Embedding)将文本字符转换为低维向量,再经双向 LSTM(长短期记忆网络)提取文本的上下文语义特征,最终输出包含语法、语义信息的文本特征向量;

核心作用:将非结构化的文本转化为结构化的特征,为后续频谱生成提供 “语义指导”。

2. 梅尔频谱生成(Decoder)

输入:编码器输出的文本特征向量;

处理流程:采用 “注意力机制 + 单向 LSTM” 架构,注意力机制负责动态关联文本特征与生成的频谱帧(解决 “哪个文本对应哪个频谱” 的对齐问题),单向 LSTM 则基于对齐后的特征逐帧生成梅尔频谱(一种贴近人类听觉系统的频谱表示);

核心作用:实现 “文本语义→声学特征” 的直接映射,这是 TTS 从 “分步” 走向 “端到端” 的关键环节。

3. 语音波形合成(WaveNet 声码器)

输入:解码器生成的梅尔频谱;

处理流程:WaveNet 作为基于卷积神经网络(CNN)的声码器,通过多层扩张卷积捕捉语音的长时依赖关系,将离散的梅尔频谱转化为连续的语音波形(采样率通常为 22050Hz);

核心作用:解决 “频谱→语音” 的最后一公里问题,是 Tacotron 2 能生成高自然度语音的核心支撑。

三、技术特点:开创与局限并存

1. 突破性技术优势

首次实现 “文本→语音” 端到端流程:摒弃传统 TTS 对人工设计中间模块(如音素词典、韵律模型)的依赖,模型可自主学习文本与语音的映射关系,极大简化了 TTS 系统的开发流程;

高自然度语音输出:搭配 WaveNet 声码器后,合成语音的语调、停顿、情感表现力远超同期开源模型(如 MaryTTS),接近专业录音师的语音质量,可满足对音质要求较高的场景;

开源生态奠基价值:作为首个大规模开源的端到端 TTS 模型,其 “编码器 - 解码器 + 注意力机制” 的架构成为后续模型(如 Tacotron 3、VITS)的设计模板,推动了开源 TTS 社区的技术迭代。

2. 不可忽视的不足之处

依赖外部对齐工具:尽管号称 “端到端”,但 Tacotron 2 的训练过程仍需依赖外部强制对齐工具(如 Montreal Forced Aligner)预先标注文本与语音的时间对应关系,否则易出现 “文本与语音不同步”(如漏读、重复读)的问题,增加了训练前的数据预处理复杂度;

实时性极差:由于解码器采用逐帧生成机制,且 WaveNet 声码器需多层卷积计算,合成 10 秒语音往往需要数分钟时间,无法满足语音助手、实时客服等 “低延迟交互” 场景;

数据依赖性强:需大规模高质量标注数据(通常要求数千小时的清晰语音 + 对应文本)才能达到理想效果,小数据集下易出现过拟合,对资源有限的开发者不够友好;

多语言支持薄弱:原生模型仅针对英文优化,对中文、日语等表意文字或小语种的适配性差,需额外进行大量语种适配开发。

四、应用场景:聚焦非实时、高音质需求

基于 “高音质但低实时性” 的特性,Tacotron 2 更适合无需实时交互、以技术验证或音质为核心需求的场景,具体包括:

1. 科研与教育场景

作为 TTS 技术入门的 “标杆模型”,高校、科研机构常以 Tacotron 2 为基础,研究端到端语音合成的注意力机制、频谱生成逻辑等核心技术,是语音合成方向研究生的经典学习案例;

用于制作教育类语音素材(如外语听力材料、有声教材),这类场景对合成速度无要求,更看重语音的清晰度与自然度。

2. 非实时内容生成场景

有声书初稿制作:出版社可利用 Tacotron 2 快速将文字书稿转化为有声内容初稿,减少前期人工录音的成本,后续仅需人工微调即可上线;

广告、影视配音初稿:在广告创意测试、影视粗剪阶段,用 Tacotron 2 生成临时配音,帮助团队快速验证内容效果,降低早期制作成本。

3. 基础 TTS 技术验证场景

企业在研发自定义 TTS 系统前,可基于 Tacotron 2 验证 “文本→频谱” 的映射逻辑,测试数据集质量、模型超参数对合成效果的影响,为后续自研模型提供参考。

总结

Tacotron 2 虽不是当前最先进的开源 TTS 模型(如 VITS 已解决其对齐与实时性问题),但它作为 “端到端 TTS 开源第一人”,彻底打破了传统技术的桎梏,为后续开源生态的繁荣奠定了基础。对于追求高音质、无需实时交互的场景,或希望深入理解端到端 TTS 原理的开发者,Tacotron 2 仍是不可替代的经典选择。