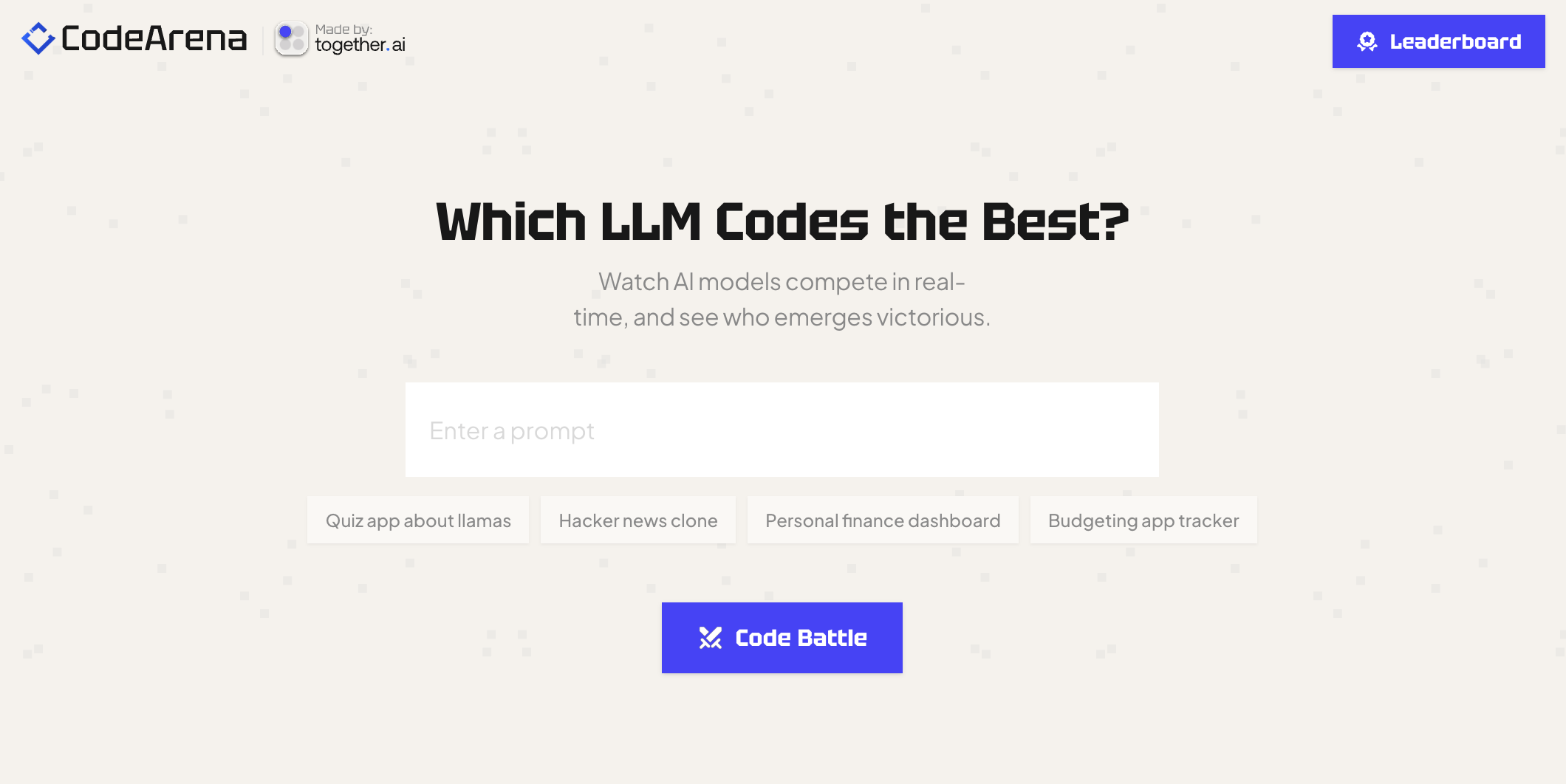

CodeArena基于 Together AI、Sandpack、Next.js、TypeScript 等技术构建,用于测试不同开源 LLM 的编程能力,实时更新排行榜。

功能特点:支持多个 LLM 同时解决相同编程问题,用户可实时观察代码生成过程和结果;根据 LLM 解决问题的效率、准确性和代码质量等因素进行排名;用户可比较不同 LLM 生成代码的可读性、效率和错误率等;集成了代码编辑器和调试工具等开发者工具。

项目官网:https://www.llmcodearena.com

一、业务目标

1. 提供直观对比平台:为开发者、数据科学家以及对大语言模型(LLM)感兴趣的群体,打造一个直观的LLM编程能力对比平台。让用户能实时观察不同LLM在解决相同编程问题时的表现,包括代码生成速度、代码结构与逻辑的合理性等,从而快速判断模型的优劣。

2. 推动模型性能评估:建立一套科学、全面的LLM编程能力评估体系。通过多种维度(如代码准确性、运行效率、代码可读性等)对模型进行量化评估,并实时更新排行榜,为行业提供有价值的参考,帮助模型研发者明确改进方向,促进LLM编程能力的整体提升。

3. 助力选型决策:帮助企业和开发者在选择适合的LLM用于编程任务时,做出更明智的决策。不同的编程场景(如Web开发、数据处理、算法实现等)对LLM的能力要求不同,CodeArena能为用户提供详细的对比数据,辅助其选择最匹配自身需求的模型,节省选型成本和时间。

二、技术原理

1. 多模型集成:整合多个不同的LLM,这些模型可能基于不同的架构(如GPT系列、开源的LLaMA等)和训练数据。通过统一的接口设计,使各个模型能够接入CodeArena平台,接收相同的编程任务指令。

2. 任务分发与执行:当用户发起编程任务时,平台将任务同时分发给接入的各个LLM。模型接收到任务后,利用自身的预训练知识和算法,生成相应的代码解决方案,并将代码返回至平台。

3. 性能监测与评估:在模型生成代码的过程中,平台会实时监测多项性能指标。例如,记录模型生成代码的时间以衡量代码生成速度;通过代码解析工具检查代码的语法错误、逻辑错误等,评估代码准确性;运用代码复杂度分析算法评估代码的可读性和可维护性;还可能通过实际运行代码,监测运行时间、内存占用等指标评估运行效率。

4. 排行榜生成:根据收集到的各项性能指标数据,平台运用特定的算法对各个LLM的表现进行综合打分和排序,生成实时更新的排行榜。该算法会根据不同指标的重要性进行加权计算,确保排行榜能准确反映模型的综合编程能力。

三、应用领域

1. 软件开发:在软件开发过程中,开发团队可以利用CodeArena平台对比不同LLM生成代码的能力,选择最适合项目需求的模型辅助开发。例如,在开发数据处理程序时,选择对数据结构和算法理解更深入、生成代码效率更高的模型;在Web开发中,选择能更好地生成符合特定前端框架(如React、Vue)规范代码的模型,提高开发效率和代码质量。

2. 教育科研:在计算机科学教育领域,教师可以借助CodeArena平台展示不同LLM的编程能力差异,帮助学生更好地理解编程概念、学习不同的代码编写思路。科研人员也可以通过该平台对比不同模型在解决特定编程问题时的表现,为模型改进和新模型研发提供数据支持和参考。

3. 人工智能研究与优化:对于专注于LLM研发的团队,CodeArena是一个重要的评估工具。通过在平台上进行对比测试,研究人员可以发现模型在编程能力方面的优势和不足,进而针对性地调整模型架构、优化训练算法、扩充训练数据,以提升模型的编程性能和泛化能力。